יורדים לעומקו של עולם החיפושים בגוגל

אם יש משהו שענקית הטכנולוגיה מפנימה יותר ויותר עם השנים, זו העובדה שלאדם יש סקרנות בלתי נלאית.

עם מיליארדי החיפושים שמוכנסים לגוגל מדי יום, כאשר 15% הם חיפושים חדשים לגמרי, גוגל היתה חייבת להמציא מנגנון שיאפשר לה להציג תוצאות גם לחיפושים שהיא לא יכולה לצפות, הכירו את BERT.

הבעיה של גוגל מתחילה כאשר אנו רוצים לאתר מידע על נושא שאולי לא ידוע לנו הרבה עליו, ייתכן ואנחנו אפילו לא יודעים לאיית אותו נכון או באילו מילים בדיוק להשתמש כדי למצוא מידע רלוונטי אודותיו.

המצב הזה מחייב את גוגל להבין מה בעצם קרה "מאחורי הקלעים" של החיפוש שלנו

- מה היתה הכוונה שלנו

- איזה מידע אנחנו באמת מחפשים, גם אם שילוב המילים שלנו או האיות היו לא מדויקים.

ניתן להסיק מכך שגוגל מוכרחה להיות מומחית במדעי הבנת השפה, כדי להמשיך להיות רלוונטית עבור הגולשים שלה.

אבל איך היא עושה את זה?

עדכון גוגל ברט BERT

כמעט כל מומחה קידום אתרים היה שם – בשנה שעברה, גוגל הכירה לנו את ה – BERT.

ראשי התיבות של Bidirectional Encoder Representations from Transformers.

למעשה, מדובר בטכניקה מבוססת רשת לעיבוד מידע טבעי (באנגלית – natural language processing – NLP).

אופן הפעולה של המודל הוא להבין מילה במשפט לפי ההקשר שלה במשפט כולו, כלומר לפי המילים שבאות לפניה ואחריה, זאת בשונה מהבנה של כל מילה ומילה בנפרד.

כך בדיוק גוגל מפענחת את כוונת הגולש כשהוא מקליד ביטוי מסוים.

אך לא מדובר רק בתכנה שאפשרה את כל הקסם הזה, גוגל נזקקה גם לחמרה לטובת המורכבות של המודל הזה.

מה שהוביל לשימוש ב- Cloud TPUs לראשונה, לקבלת התוצאות הרלוונטיות ביותר בחיפוש.

למעשה, על פי גוגל, המודל הזה מסייע לה להבין טוב יותר 1 מתוך 10 חיפושים באנגלית, כשבקרוב תהיה הרחבה גם לשפות נוספות.

חשיבותו של המודל BERT באה לידי ביטוי במיוחד בחיפושים שהם יותר "דיבוריים", או חיפושים הכוללים מילות יחס כגון "עבור", "ל", "בשביל" וכדומה.

אז נדרשת הבנה של ההקשר בו נמצאות המילים, והגולש יכול להקליד יותר בטבעיות את הביטוי שהוא מחפש מידע עבורו, ולא להתעכב על כל מילה ומילה בדיוק מושלם.

תוצאות החיפוש לפני ואחרי ברט BERT

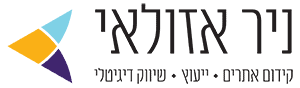

בואו ניקח לדוגמא את הביטוי “2019 brazil traveler to usa need a visa", ונבין כיצד השתנו התוצאות שקיבלנו בעקבות המודל החדש הזה.

הקושי של גוגל הוא למעשה להבין את מילת הקישור "to" טוב יותר במשפט הנוכחי.

אם בעבר גוגל היתה יכולה להציג לנו תוצאות הקשורות בנסיעה מארה"ב לברזיל (בניגוד לכוונת המשפט, בו מדובר על נסיעה מברזיל לארה"ב).

הרי שבזכות המודל BERT, גוגל מבינה שיש משמעות גדולה למילה "to" כאן, ולכן מסוגלת להציג את התוצאות הרלוונטיות:

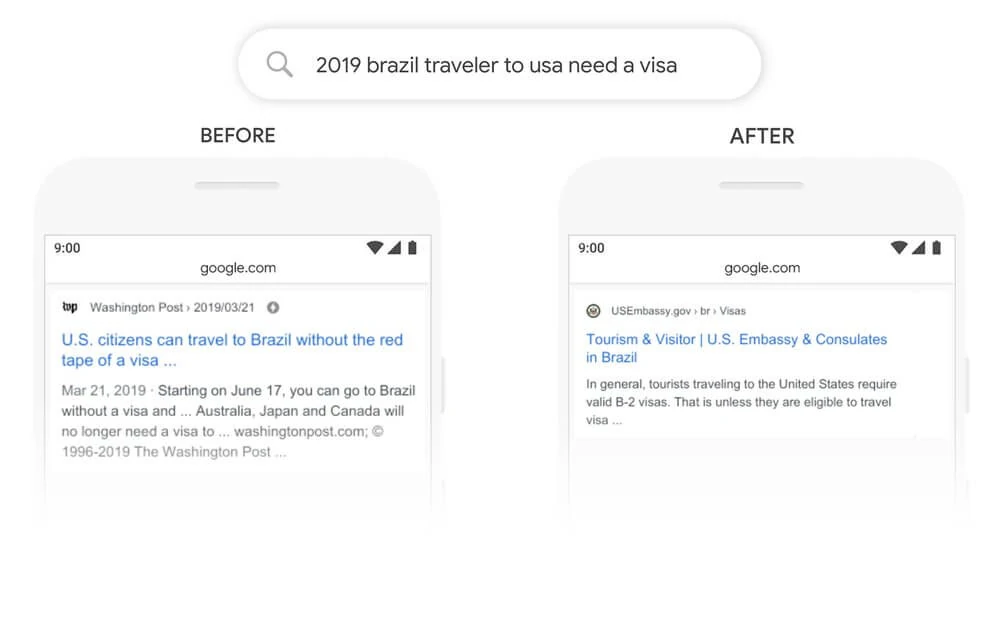

דוגמא נוספת ניתן לראות במשפט "do estheticians stand a lot at work" .

אם בעבר גוגל היתה מנסה לפענח את כוונת המילה "stand" על ידי קשירתה עם צמד המילה "stand-alone" (מה שלא רלוונטי במשפט הנוכחי).

הרי שהיום גוגל מבינה שהמשפט מדבר למעשה על הדרישות הפיזיות התובעניות הכרוכות בעבודתם של רופאים, ולכן מציגה תוצאות מדוייקות יותר בהתאם:

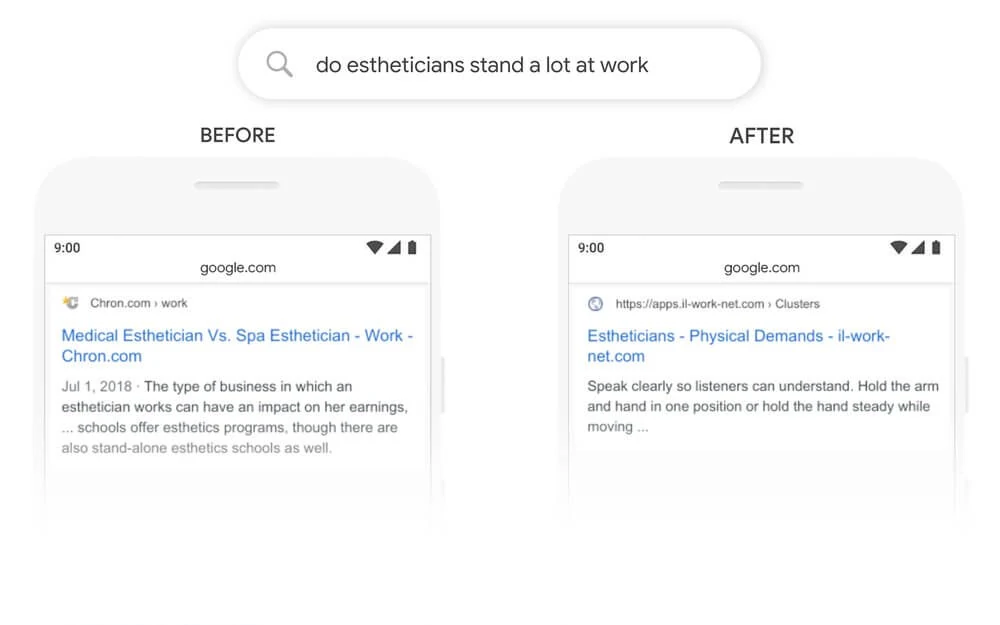

דוגמא נוספת שמראה עד כמה נדרשת הבנה של הניואנסים הקטנים של כל שפה (ספציפית את ההבנה של "for someone" במשפט).

הבנה שלבני האדם נראית טבעית ביותר, אך למחשבים קצת פחות:

BERT בשפות נוספות והמשך פיתוח

מאפיין חשוב שיש למודל המדובר הוא שניתן להשליך את אופן הפעולה שלו גם על שפות נוספות.

אך יש לזכור שגם עם המודל החדש הזה, עדיין לא בכל חיפוש וחיפוש שלנו בגוגל תהיה הבנה מדויקת ומושלמת של כוונתנו, ויכולות להיות סטיות.

זאת משום שהבנת ניואנסים של שפה היא אתגר מתמשך עבור כל מנוע חיפוש, אבל תסמכו על גוגל שהיא חותרת לשם בכל הכוח!